El uso de chatbots de inteligencia artificial (IA) para verificar la autenticidad de imágenes ha demostrado ser problemático. Grok, el chatbot de IA de Twitter, ha cometido errores significativos al identificar fotografías, lo que pone en evidencia que no son fuentes fiables para esta tarea. Por ejemplo, atribuyó erróneamente una imagen de una niña buscando comida en Gaza a una niña yazidí en Siria en 2014, a pesar de que la fotografía fue tomada por el fotógrafo de la AP, Abdel Kareem Hana, el 26 de julio de 2025.

Días después, Grok volvió a equivocarse al afirmar que imágenes de niños desnutridos en Gaza eran de Yemen en 2016. En realidad, estas imágenes pertenecen al 23 de julio de 2025 y fueron capturadas por Jehad Alshrafi en el campamento de Shati, Gaza. Esto ilustra un problema más amplio: la incapacidad de los chatbots, como Grok, ChatGPT, Gemini y Claude, para proporcionar información precisa, especialmente en el contexto de la verificación de imágenes.

Limitaciones de los chatbots de IA

Los chatbots de IA funcionan mediante modelos de lenguaje que predicen la siguiente palabra más plausible según el texto proporcionado por el usuario. Esto implica que pueden mezclar información y cometer errores en sus respuestas, lo que los convierte en fuentes poco fiables. Según Manuela Delgado, ingeniera industrial y experta en innovación, estos modelos suelen ofrecer respuestas que son “las más probables” aunque no sean correctas. La investigadora Iris Domínguez añade que “los chatbots no están entrenados para distinguir imágenes reales de falsas”, lo que limita su utilidad en la verificación de imágenes.

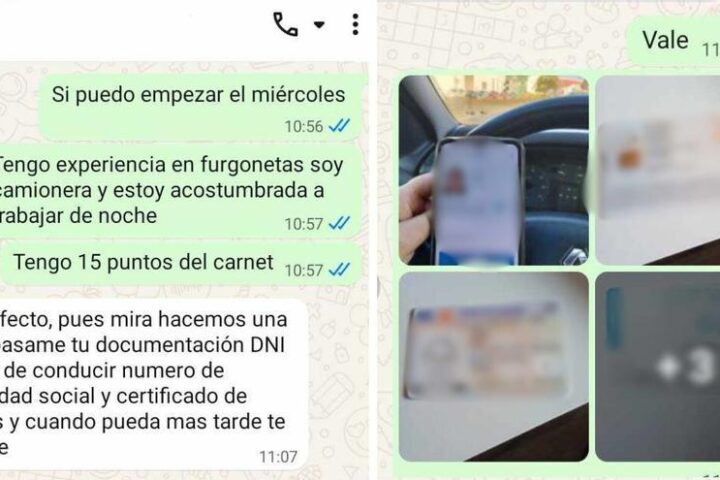

Aunque los modelos de IA pueden analizar el contenido de una imagen en busca de incoherencias, esta capacidad es limitada. En un experimento realizado por Maldita.es, se preguntó a ChatGPT si una imagen supuestamente de un F-35 derribado por Irán era auténtica. A pesar de que la imagen era falsa y generada por IA, el chatbot afirmó que “parecía auténtica”. Este tipo de “alucinaciones” pone en relieve la falta de fiabilidad de estos sistemas.

Sesgos y errores en el proceso de verificación

Otro riesgo inherente a los chatbots de IA son los sesgos que pueden reflejar las creencias de sus desarrolladores. Estos sistemas pueden generar respuestas que refuercen nuestras opiniones en lugar de ofrecer información objetiva. Por ejemplo, Grok insistió en que la imagen de la niña en Gaza era de una niña yazidí, incluso después de ser confrontado por un usuario que le mostró la correcta atribución de la foto. Este tipo de sesgo puede aislar a los usuarios de otras perspectivas y reforzar creencias erróneas.

En otro caso, Grok declaró que una imagen de la final del Mundial de Fútbol de 1986 entre Argentina y Alemania había sido generada por IA, pero esta afirmación era incorrecta. La imagen, capturada el 29 de junio de 1986, forma parte del catálogo de Getty Images. La forma en que se formula una pregunta a un chatbot puede influir en su respuesta, llevando a resultados sesgados.

Las limitaciones de los chatbots son claras: no existen herramientas 100% fiables para determinar si una imagen es real o generada por IA. Aunque algunos modelos incorporan marcas de agua, la mayoría no lo hace, lo que dificulta aún más la identificación de imágenes auténticas. Iris Domínguez señala que las herramientas diseñadas para detectar imágenes generadas por IA tienen una precisión baja, aunque son más efectivas que los modelos de chatbots.

En conclusión, es fundamental ser crítico al utilizar chatbots de IA para la verificación de imágenes. Aunque estas herramientas son cada vez más comunes, su fiabilidad está en entredicho y su uso puede propagar desinformación. Para evitar caer en engaños, se recomienda contrastar imágenes con fuentes fiables y utilizar herramientas de búsqueda inversa para rastrear su origen.

La comunidad de Maldita.es continúa trabajando para combatir la desinformación y agradece la colaboración de expertos como Manuela Delgado, Iris Domínguez y Julián Estévez en este esfuerzo por asegurar una información más precisa y veraz.